余露.自动驾驶汽车的罗尔斯式算法——“最大化最小值”原则能否作为“电车难题”的道德决策原则[J].哲学动态,2019(10):100-107.

自动驾驶汽车的罗尔斯式算法——“最大化最小值”原则能否作为“电车难题”的道德决策原则

余露

湖南师范大学道德文化研究中心、人工智能道德决策研究所

摘要:自动驾驶汽车必须拥有应对“电车难题”的道德决策程序。为此,人们援引伦理理论构想了不同的算法,如功利主义的、康德式的。雷本深受罗尔斯道德理论的启发,借用厚实的“无知之幕”和“最大化最小值”原则,设计了一套可操作的罗尔斯式算法,并给予相当程度的辩护。但罗尔斯式算法因其误解了罗尔斯的意图而错误地适用了“最大化最小值”原则,导致其产生了无法解决的困境。

关键词:自动驾驶汽车;电车难题;罗尔斯式算法;最大化最小值原则;

基金:国家社会科学基金重大项目“大数据环境下信息价值开发的伦理约束机制研究”(17ZDA023)的阶段性成果

目前,人工智能正逐步地应用到人类生活的各个领域,甚至开启人工智能时代,这是我们不得不面对的最迫近的未来;与之相应,很多伦理困境也变得越来越急迫而复杂。比如,“电车难题”,面对突然闯入马路的行人,来不及刹车的司机是应该直接撞上行人,还是急转弯将自己(和/或乘客)置身险境?对于自动驾驶汽车而言,对这一困境的处理迫在眉睫,因为它必须被置入相应的决策程序才可能被批准上路,没有人会愿意将自己的生命交付给不确定决策的交通工具。

为了作出切实有效的道德决策、划定清楚明晰的道德责任,人们援引不同的伦理理论构想了不同的算法。1一种自然的选择是功利主义的,它诉诸于人类最本然的道德直觉:在伤害不可避免的情况下,我们要尽量让伤害最小化(即让结果达致最大功效)。这一思路得到了克里斯多夫·格鲁(Christopher Grau)的支持,在《“机器人”没有“我”:机器人与功利主义》一文中,格鲁为功利主义的算法提供了辩护。2这一算法也得到了实证调查的支持,绝大多数的受调查者认为,在“电车难题”中,功利主义的方案(即保全更多人的生命)是最道德的。然而,他们更喜欢自我保护模式的自动驾驶汽车。3这可以通过康德式的算法实现,这种算法依托于可普遍化原则的纯形式特征。在《展望康德式机器》一文中,托马斯·鲍沃斯(Thomas M.Powers)援引“绝对命令”为机器伦理学提供了康德式的解释进路。鲍沃斯从“绝对命令”起作用的三种方式——纯粹一致性(mere consistency)、共识实践推理和连贯性(coherency)出发,并借用道义逻辑和缺省逻辑等工具,设计了一种道义论的算法。4但正如鲍沃斯自己意识到的,康德式算法也会面临各式各样的挑战,如琐碎性、缺乏优先规则等。

在《自动驾驶汽车的罗尔斯式算法》5一文中,德瑞克·雷本(Derek Leben)提供了另一种可能的方案。他援引罗尔斯在《正义论》中所阐释的“最大化最小值”原则,为自动驾驶汽车应对“电车难题”设计了一套算法。本文将聚焦于雷本的罗尔斯式算法,在对其进行简单介绍的基础上讨论其可行性,进而探究“最大化最小值”原则能否作为不确定情境的道德决策原则。

一 罗尔斯式算法

顾名思义,“罗尔斯式算法”是受罗尔斯所提出的方法和原则的启发。在呈现算法前,雷本概要地回忆了罗尔斯在《正义论》中对“最大化最小值”原则的论述。

首先,罗尔斯承袭了契约论传统。雷本指出,契约论包括元伦理学和规范伦理学两个层面。在元伦理学层面,契约论认为,道德原则和判断是用以促成自私的个体参与合作的,道德的功能在于促使博弈双方都达致“帕累托最优”,即没有任何一方能够在不使得其他各方利益受损的情况下提升利益。在规范伦理学层面,契约论指出,社会合作最佳的解决方案在于各方从某一理想的情境出发所达成的(假然的或实然的)协议。

其次,在罗尔斯的文本中,理想的情境是由“无知之幕”造就的。在“原初状态”下,各方对自己的特殊信息都一无所知,比如,他们在社会中的地位。因而,雷本认为,原初状态的方法不能广泛地应用于一切情境,它只能适用于分配那些每个人都同等欲求的善物(goods),比如罗尔斯所言的“基本善物(primary goods)”。当我们分配计算器和熔岩灯时,原初状态的方法就用不上,因为总有些人完全不想要计算器。但是,雷本指出,“因为自动驾驶汽车所做的决定影响到健康和生存的分配,因而,自动驾驶汽车的决策程序是道德相关的”。在这里,“道德相关”并非在泛泛的意义上讨论自动驾驶汽车在事故中决策是具有道德属性的,在雷本看来,自动驾驶汽车的事故算法可以适用原初状态的方法,进而援引相应的决策原则。这是雷本工作的起点,我们在第三部分会对此进行详细讨论。

最后,原初状态下的无知之幕是厚实的6,它遮蔽了决策所影响的个体数量以及每个特定个体的收益,使任何概率的演算都变得不可能,因而,理性的人就会遵循“最大化最小值”原则进行决策。“最大化最小值”原则敏感于最小收益,倾向于选择能够使得最小收益最大化的决策方案。

在此基础上,雷本为自动驾驶汽车设计了一套算法,用以在“电车难题”困境中进行道德决策。

这一模型包括三类实体(entities),即被自动驾驶汽车的行动所影响的个体(Players:P1,P2,…,Pn)、自动驾驶汽车所采取的行动(Actions:A1,A2,…,An)以及表征每个行动下个体收益的功利函数(utility function)。功利函数基于个体的“生存概率”这一单一的维度进行计算(假定自动驾驶汽车足以评估个体生存的可能性),用0到1之间的数值表示。换言之,在自动驾驶汽车的罗尔斯式算法中,所被分配的“善物”即是个体的生存。

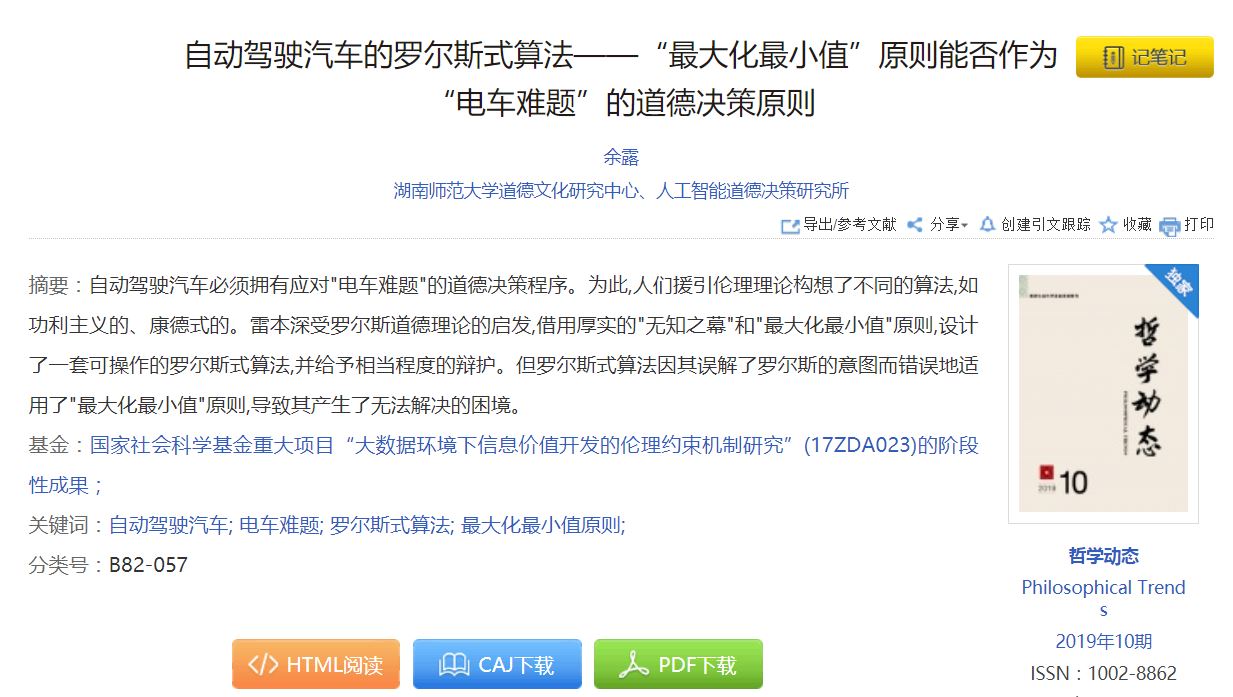

罗尔斯式算法包括两个步骤:第一,对行为进行数据表征;第二,依据流程图进行运算。每个行为都由受此行为影响的个体的生存概率所组成的矩阵来表征,比如,当自动驾驶汽车采取行为A1时,受其影响的个体P1、P2的生存概率分别为0.25、0.70,则A1刻画为A1:(0.25,0.70)。待所有行为都用此方式进行刻画后,便依据如下流程表(图1)进行计算、决策。

图1

此流程图是雷本对罗尔斯“最大化最小值”原则的一个具体应用。如上所说,雷本认为自动驾驶汽车所面临的“电车难题”实际上就是如何分配健康和生存的问题,健康和生存是每个人欲求的,因而可以适用“最大化最小值”原则。进一步,程序员在为自动驾驶汽车编写决策程序时,并不知道“电车难题”涉事人员的人数和其他任何个体特征,亦即此情境类似于“无知之幕”所塑造的理想情境,因而,“最大化最小值”原则成为最优选择。

为了更好地理解雷本的设想,笔者结合《自动驾驶汽车的罗尔斯式算法》一文中所提及的案例,以及自动驾驶汽车可能遇到的“电车难题”设计了如下情境。

清晨,自动驾驶汽车搭乘若干乘客(限乘人数内)按照规定限速行驶在高架桥上,一行道路维护工人突然从花带中走出准备作业(无明显过错)。此时,自动驾驶汽车已无法通过行车制动器停止,它只有两个选择:一是在开启制动的同时继续前行,造成工人死伤;二是急速转弯撞向防护栏,造成乘客死伤。根据雷本的假定,自动驾驶汽车可以借助自身速度、撞击角度、涉事人员的身型来计算每个人的生存概率。

1.1假定车上搭乘2人,道路维护工人3人。通过计算,减速直行时,乘客因受到冲击较少且有车载防护措施,几乎不会受伤,工人因身型、撞击角度差异,生存概率分别为0.01、0.01、0.35;急速转弯时,工人不会被撞击而几乎毫发无伤,乘客因身型、撞击角度差异,生存概率分别为0.01、0.25。则两行为分别刻画如下:

A1[直行]:(0.99,0.99,0.01,0.01,0.35)

A2[转弯]:(0.01,0.25,0.99,0.99,0.99)

我们将数据输入,得到第一组最小收益集为(0.01,0.01),由于两数值相同,则需继续比较其他收益值。遮住所有0.01的收益,在剩下收益值中挑选最小值,组成第二组最小收益集为(0.25,0.35),由于0.35大于0.25,所以选择产生0.35收益的行为,即直行。

我们可以将之简单地与功利主义算法进行对比。在笔者获取的有限资料里,并没有发现有学者给出功利主义算法的演算路径,但我们可以粗略地依据功利主义进行决策。如果我们将每个涉事人员算作一个单位:如受损较少,甚至毫无损害,则记作正单位(+1);如受损较多,甚至死亡,则记作负单位(-1)。求和之后的结果为A1(-1)、A2(+1),-1小于+1,则选择A2,即转弯。如果我们利用生存概率求和,A1(2.35)、A2(3.23),2.35小于3.23,那么选择A2,即转弯。也就是说,植入功利主义算法的自动驾驶汽车在1.1情境中会转弯;而如上所述,拥有罗尔斯式算法的自动驾驶汽车则会选择减速直行。

1.2假定车上搭乘1人,道路维护工人1人。

通过与1.1类似的计算,两行为分别刻画如下:

A1[直行]:(0.99,0.01)

A2[转弯]:(0.01,0.99)

我们将数据输入,得到第一组最小收益集为(0.01,0.01)。因数值相同,需继续比较。第二组最小收益集为(0.99,0.99),数值仍相同,仍需继续比较。但因无其他收益值可供比较,则随机输出。也就是说,依据罗尔斯式算法,在1.2情境中,直行和转弯都可选择。

二 批评与回应

在描述算法并进行简单应用后,雷本设想了三个可能的反驳并作出回应,本节将对此进行深入讨论。实际上,雷本在进入自我辩护之前,还回应了另外一类反驳,笔者也将之重构出来。

第一个反驳指出,当第一组最小收益集中的数值有两个或两个以上相同,我们需要继续比较第二组最小收益集中的数值时,我们不应该遮住所有最小值。以1.1为例,第二组最小收益集应为(0.01,0.25),而非如雷本的算法所示,为(0.25,0.35)。

雷本再次强调,他所依赖的是罗尔斯式的厚实的“无知之幕”,涉事人员的数量以及我们会成为其中的何者之概率是未知的,因而要遮住所有最小值。当然,他也承认,人们可以设计薄版本的契约论算法,而且,这种算法仍会在一些情境中得出与功利主义算法不一样的结果。

第二个反驳认为,我们在对行为进行数据表征时,不应该仅仅依据生存概率。“毕竟,当生存以年龄或社会重要性的维度进行转换时,生存拥有着不同的价值。”同样是50%的生存概率,耄耋老者与舞勺少年的生存价值各异,重症缠身与身强力壮的生存价值也差别悬殊。

雷本部分地接受这种反驳,并进而提出了一种可能的修正。他认为,健康如生存一样,应被纳入“基本善物”的清单。我们可以将“质量调整寿命年(QALYs)”引入数据表征中,即在涉事人员的生存概率中加入年龄和健康状况的权重。比如,某一行为造成两位涉事人员的生存概率为(0.5,0.8),他们遭遇此次事故前剩余的质量调整寿命年为(30,5),则此行为被刻画为(15,4)。但是,雷本也意识到这种修正“如履薄冰”,因为它极易滑向将社会价值纳入计算的泥沼,而这与罗尔斯设置“无知之幕”的动机有些背道而驰。因此,他明确指出:“虽然我认为使用质量调整寿命年在原初状态下可以得到证成,但它比仅仅使用生存概率带来了更多的政治风险。”

笔者并不认可雷本的修正。如果如雷本所言,自动驾驶汽车可以根据医疗档案来估算涉事人员的“质量调整寿命年”,那么,在最初计算每个涉事个体的生存概率时就不应单以车速、撞击角度和身型为衡量标准。同样的撞击力和作用对象,在对象处于心脏病和健康状态下产生的伤害结果肯定不一样。或许自动驾驶汽车应该被置入更为复杂且精准的生存概率计算程序。但更为重要的是,雷本的修正混淆了生存和生存的价值。在《正义论》中,罗尔斯明确地区分了自由与自由价值:“自由表现为平等公民权的整个自由体系;而个人和团体的自由价值是与他们在自由体系所规定的框架内促进他们目标的能力成比例的。”7虽然罗尔斯并不反对对较少自由价值进行补偿,但他明确指出:“对较少的自由价值的补偿和对不平等自由的补偿这两者不能混为一谈。”7如果像雷本所确信的那样,生存属于罗尔斯所言的“基本善物”,那么它应该归属于“自由”,而非“自由价值”。在罗尔斯看来,我们应该确保一切人都享有平等的自由,同时又最大限度地提高最少受惠者的自由价值。这正是罗尔斯的“正义两原则”所要达致的目标。然而,罗尔斯式算法无法兼顾生存和生存价值:如果我们以单一的“生存概率”为维度,则生存只能被平等地分配,生存价值无从得以补偿;如果我们考虑生存价值,将“质量调整寿命年”纳入对行为的数据表征,那么,我们就没有理由将生存的社会价值排除在外。毕竟,当我们清清楚楚地知道涉事人员分别是正在研发抗癌药物的科学家和有无数犯罪前科的工人时,直觉会促使我们偏爱科学家。或许对于雷本而言,最好的回应仍是借助于“厚实的无知之幕”,撇除生存价值的干扰。但是,我们已清晰地看到罗尔斯式算法与罗尔斯正义理论之间的裂缝。

第三个反驳则关注反向不公。这种观点认为,如果我们将生存概率最小者作为影响决策的关键因素,那么,安全系数更高的自动驾驶汽车就会成为“靶子”,这显然是不公平的。与骑摩托车是否戴头盔一事类比。据官方统计数据表明,戴头盔可以让摩托车骑行者在事故中的死亡率降低22%—42%。如果摩托车骑行者知道自动驾驶汽车的事故算法会优先保护生存概率最低者,他们是否会从此不再戴头盔呢?因为“头盔”很可能因其安全性而让戴头盔的骑行者成为“靶子”。

对此,雷本给出了两个回应。第一,罗尔斯式算法的目的在于“编程以避免导致较低的最小生存值”,而非旨在“撞击”高生存概率者或以他们为“靶子”。这种反驳误解了罗尔斯式算法的目的和意图。第二,这种反驳的推理存在谬误。即便在“电车难题”情境中,戴头盔的摩托车骑行者恰好因生存概率高于其他涉事者而成为决策的牺牲者,这也不意味着摩托车骑行者应该选择不戴头盔,毕竟两难困境是极其罕见的情境,在大部分情境中戴头盔仍会减少风险。雷本提请我们将之与系安全带类比。虽然在极个别的事故情境中,安全带因缠绕、勒紧等意外状况导致伤害甚至死亡,但安全带仍被叫作“安全的”,且在汽车行驶过程中被明文强制使用,因为它确确实实是一种安全保护措施。与此相似,戴头盔和安全系数高的汽车仍然是我们的选择,它们在绝大多数情境下是保护我们的设备。

第四个反驳强调罗尔斯式算法的反直觉性。这种反驳指出,在一些情境中,罗尔斯式算法会产生反直觉的决策。比如在1.1情境中,拥有罗尔斯式算法的自动驾驶汽车会遵循“最大化最小值”原则减速直行,导致的结果是:两人生还、两人死亡和一个生存概率为0.35的伤者。而功利主义算法所推荐的急速转弯,其结果是:三人生还、一人死亡和一个生存概率为0.25的伤者。直觉上,我们似乎更愿意第二种结果发生。

雷本在回应前首先指出:“任何依赖于一个一致的道德原则(设计的)算法都可能产生反直觉的决策。”对此,雷本并没有给出更多的解释,笔者试图予以补充。虽然立场相反,但威廉斯与斯洛特都提到了系统化、统一化的道德理论与复杂性、多样性的道德直觉之间的张力。8威廉斯批判性地指出:“伦理学理论的目的毋宁在于消解冲突,更强意义上地消解冲突:它应该提供某种令人信服的理由去接受这种而非那种直觉。”9而这正是斯洛特努力的方向:“我们关于道德的常识思考是内在地不一致的,而这种不一致性使我们有理由以一种在哲学的其他领域曾经被践行过的方式去追求伦理学的系统性理论。”10也就是说,任何一种以一致性原则为出发点的道德理论确实无法包容多样化的道德直觉。那么,依据某一特定原则设计的事故算法自然也无法与所有的直觉相符,因为道德直觉本身就存在不一致性、冲突性。

在此之后,雷本作出的回应是针对他所设想的情境而言的,所以,我们暂时将1.1情境搁置,先讨论雷本的情境和回应。

2.1自动驾驶汽车面临着这样一个两难困境:要么直行,撞向一个行人,导致其死亡;要么转弯,撞向一组行人,致使他们严重伤残。

依据“最大化最小值”原则,自动驾驶汽车应该转弯,因为较之死亡,伤残显然是更大的收益值。但这似乎让人无法接受:为了避免一个人的死亡,却要使得很多人变得严重伤残,比如瘫痪。

雷本对此给出了三方面的解释。第一,2.1情境出现的可能性微乎其微。他指出,如果自动驾驶汽车无法避免撞向一个人或一行人,那么两组行人受到的伤害大体是相当的。也就是说,一行人的伤残程度肯定在可接受范围内。第二,即便我们承认罗尔斯式算法给出的决策是反直觉的,但道德理论并不依赖于直觉,反而是出自对直觉的“羞愧”。不过,雷本有个退让,认为罗尔斯不会作出这个回应,因为他要求我们应该在道德原则与直觉之间达致“反思平衡”。其实,雷本无需回撤,而只需调整其表述。如笔者对威廉斯和斯洛特的引述,直觉因其不一致性确实无法毫无遗漏地进入道德理论之中。罗尔斯的理论也毫不例外,他在强调原则与判断的“反思平衡”时,一方面强调修正原初状态的解释,另一方面也强调对判断的修改。11所以,雷本只需强调道德理论只依赖部分直觉、并非全部直觉即可,这也与其回应之前的论断相符。第三,罗尔斯式算法为2.1作出的决策并不那么违反直觉。如果我们确乎有相同的概率成为那个行人或者一组行人中的某一个,我们或许都会希望成为伤残而非死亡的那一个。进一步,如果2.1情景稍加变换,将死亡和瘫痪换成瘫痪和断腿,罗尔斯式算法的决策就明显地符合直觉了。

最后,雷本承认,他的描述是一种“简化”,他只考虑了孤立的自动驾驶汽车面对“电车难题”时的情境,并没有将之纳入自动驾驶汽车的连接网络之中,而后者恰恰是汽车公司的发展模式。但雷本相信,罗尔斯式算法是“最有价值的,如果罗尔斯的理论被证明是正确的”,其主要的优点在于,“它将每个人作为平等的个体予以尊重,而且,它不会为了他人的利益而牺牲每个个体的利益”。

三 “最大化最小值”原则的限度

在上一部分,笔者陈述并完善了雷本对反驳的回应,为罗尔斯式算法给予了部分辩护。但这并不意味着笔者赞同罗尔斯式的事故算法。在笔者看来,罗尔斯式算法最大的困境并不在于上述四个反驳,而在于其算法在何种意义上是“罗尔斯式”的?它是否可以是“罗尔斯式”的?换言之,“最大化最小值”原则是否可以充当自动驾驶汽车遭遇“电车难题”时的决策原则?这就关涉“最大化最小值”原则的限度问题。

值得提及的是,“最大化最小值”原则的限度问题并非新话题,早在罗尔斯将其用于“原初状态”的决策原则时就出现了一系列批评。比如,哈桑伊(Harsanyi)就认为在不确定情境中,贝叶斯定理是较之“最大化最小值”原则更好的决策原则。12但是,本文不打算泛泛地讨论“最大化最小值”原则的适用范围,也不探讨罗尔斯将“最大化最小值”原则用于原初状态是否站得住脚,而只将关注点聚焦于雷本的应用,即假设罗尔斯的理论是正确的,罗尔斯式算法是否真如雷本所言“最有价值”呢?

针对学者对“最大化最小值”原则的批评,罗尔斯曾明确指出:“最大化最小值的规则一般来说并不是不确定性选择的可靠指导,它仅在某些具有专门特征的境况中是有效的。”这些特征包括:第一,有理由不考虑可能环境的可能性;第二,选择者认为,为了进一步的利益冒险是不值得的;第三,被拒斥的选择有选择者不可接受的后果。13罗尔斯认为,在“无知之幕”遮蔽之下的原初状态很好地满足了这三个特征,因而,“最大化最小值”原则可以有效地适用。

雷本一再强调他援引的是罗尔斯的厚实的“无知之幕”:在给自动驾驶汽车预置事故算法时,我们并不知道涉事的人数以及我们在事故中扮演着怎样的角色。所以,偏好最大的最小收益值是合理的,毕竟我们有相当的概率成为伤残最重的那一个。

但是,有人可能会提出如下两类质疑。第一,事故算法总是会带着程序员的气质,不同气质的程序员会青睐不同的决策原则。最新的研究表明,人们的分配选择与他们的风险偏好极其匹配,罗尔斯主义者会尽量避免高风险决策,让分配方案中的最小收益值最大化,但功利主义者则偏爱拥有最大的总体收益的分配方案,他们喜欢高风险但有高收益的选项。14这种质疑很容易予以回应。我们是在为自动驾驶汽车面对“电车难题”时找寻最优决策原则,并非探究在现实生活中程序员会写出怎样的算法,因而,“冒险”这一气质完全可以不被纳入考量。

第二,如果“电车难题”的情境符合厚实的“无知之幕”,我们就没有任何计算概率的基础,那么用来表征行为的生存概率是如何被计算的呢?让我们回忆一下罗尔斯对“无知之幕”的论述:“无知之幕”下的各方不知道任何与己相关的特殊事实,但他们知道有关人类社会的一般事实和普遍法则。15我们可以根据一般的物理学知识来计算涉事人员的生存概率。但也正因如此,笔者并不认可雷本在数据表征中加入“质量调整寿命年”的做法,医疗记录等其他健康档案都属于个体的特殊事实,这一修正违背了厚实“无知之幕”的设定。

罗尔斯式算法因分享了厚实的“无知之幕”而带有了罗尔斯理论的气质。然而,它还面临着更为严峻的考验。罗尔斯对“最大化最小值”原则的适用还有更为严苛的限制条件。

在罗尔斯看来,社会正义的主题是社会的基本结构,它分配的是基本权利和义务,更准确地说,是由社会合作产生的利益和负担,“并不是那种临时给个人分配某些数额的钱、财产或别的什么的问题”15。雷本实际上注意到了这一限制,只是他巧妙地将重点放在了社会合作产生的利益——“基本善物”之上,进而,他认为生存和健康都是人们一般地意欲得到的,具有“基本善物”的属性。但是,雷本的这一转化错失了罗尔斯根本的诉求。“基本善物”确实是人们普遍想要的,但并非人们想要的东西就属于罗尔斯所称的“基本善物”。“基本善物”是针对“政治领域”而言的,它们具有两方面的特质:一方面,它们是社会合作所产生的利益;另一方面,它们也是个体成为社会合作成员、实现公民能力的手段。16

为了确保“基本善物”的公平分配,罗尔斯提出了两条正义原则以及两条优先原则,即自由的优先性,以及公平的机会优先于差别原则。15也就是说,只有在平等的自由和公平的机会满足之后,“最大化最小值”原则才会起作用,践行差别原则。通过这一系列规则,罗尔斯在确保一切人享有平等的自由体系的前提下尽可能地提高最小收益者的自由价值。如前所述,就是在这里,雷本的罗尔斯式算法与罗尔斯的理论产生了不可逾越的鸿沟,因为生存和健康并不是罗尔斯的正义理论关切的对象。而且,也正因为此,雷本没有给反驳二以令人满意的回应,1.1情境所呈现的反直觉后果也不是雷本的回应所能解释的。

综上所述,在笔者看来,虽然雷本为自动驾驶汽车面对“电车难题”给出了可操作的“罗尔斯式算法”,但这一算法只在极其有限的意义上是“罗尔斯式”的,而且,由于雷本对罗尔斯适用“最大化最小值”原则的限制理解不够深入,导致了“罗尔斯式算法”产生了无法解决的困境。

注释

1.依据瓦拉赫和艾伦的区分,本文讨论的算法都属于自上而下的进路。关于自上而下、自下而上以及混合进路的区分和讨论,可以参见温德尔·瓦拉赫、科林·艾伦:《道德机器:如何让机器人明辨是非》,王小红主译,北京大学出版社,2017。则

2.C.Grau,“There Is no ‘I’ in ‘Robot’: Robots & Utilitarianism”, IEEE Intelligent Systems,21(4),2006,pp.52—55.

3.Jean-Francois Bonnefon, Azim Shariff, Iyad Rahwan,“The Social Dilemma of Autonomous Vehicles”,Science,352(6293),2016,pp.1573—1576.

4.Thomas M.Powers, “Prospects for a Kantian Machine”, IEEE Intelligent Systems,21(4),2006,pp.46—51.

5.Derek Leben, “A Rawlsian Algorithm for Autonomous Vehicles”, Ethics & Information Technology,19,2017,pp.107—115.以下关于雷本的论述,都直接或间接引自本文,后面不再一一加注。

6.关于“无知之幕”厚、薄的讨论,参见《道德理论中的康德式建构主义》,载《罗尔斯论文全集》,陈肖生等译,吉林出版集团有限责任公司,2013。

7.罗尔斯:《正义论》(修订版),何怀宏、何包钢、廖申白译,中国社会科学出版社,2009,第160页;第160页。

8.关于道德理论与道德直觉之间的张力,参见B.威廉斯:《伦理学与哲学的限度》,陈嘉映译,商务印书馆,2017,第6章;迈克尔·斯洛特:《从道德到美德》,周亮译,译林出版社,2017,第3章。值得注意的是,在此两书中,威廉斯与斯洛特也呈现了完全不同的工作路径:威廉斯反对基础主义的伦理学进路,主张从人的视角来看待世界,调动一切资源来促进我们对自我生活的关切。斯洛特则试图借助于“可赞赏性”等中性概念,以基础主义的方式构建一种系统的常识美德伦理学。

9.B.威廉斯:《伦理学与哲学的限度》,第121页。

10.迈克尔·斯洛特:《从道德到美德》,第43页。

11.罗尔斯:《正义论》(修订版),第16页。

12.Cf.John C. Harsanyi,“Can the Maximin Principle Serve as a Basis for Morality? A Critique of John Rawls's Theory”, The American Political Science Review,69(2),1975,pp.594—606.

13.罗尔斯:《正义论》(修订版),第120页。这三个特征后来成为批评和辩护的争论核心,如Olaltunji A. Oyeshile (2008),Robert C. Robinson (2009)。

14.T.Kameda,K.Inukai,S.Higuchi,A.Ogawa,H.Kim,T.Matsuda,and M.Sakagami, “Rawlsian Maximin Rule Operates as a Common Cognitive Anchor in Distributive Justice and Risky Decisions”,Proceedings of the National Academy of Sciences of the United States of America,113(42),2016,pp.11817—11822.

15.罗尔斯:《正义论》(修订版),第105—106页;第6、122页;第237页。

16.参见罗尔斯:《政治自由主义》,万俊人译,译林出版社,2002,第80—82页。